Agent fiduciaire du SCW : AI

Visibilité et contrôle complets sur le code généré par l'IA. Innovez rapidement et en toute sécurité.

%201.avif)

Amélioration de la productivité,

mais augmentation des risques

L'adoption généralisée des outils de codage IA, des LLM et des MCP pose un nouveau défi : le manque de visibilité et de gouvernance sur le code généré par l'IA.

78%

- StackOverflow

30%

- arXiv

50%

- BaxBench

Les avantages de l'agent de confiance : AI

Les nouvelles capacités d'IA de SCW Trust Agent offrent l'observabilité et le contrôle approfondis dont vous avez besoin pour gérer en toute confiance l'adoption de l'IA dans votre cycle de développement logiciel (SDLC) sans sacrifier la sécurité.

Le défi de l'IA dans votre SDLC

Sans moyen de gérer l'utilisation de l'IA, les RSSI, les responsables de l'AppSec et de l'ingénierie sont exposés à de nouveaux risques et à des questions auxquelles ils ne peuvent pas répondre. Voici quelques-unes de ces préoccupations :

- Manque de visibilité sur les développeurs qui utilisent tel ou tel modèle.

- Incertitude quant aux compétences en matière de sécurité des développeurs qui utilisent des outils de codage de l'IA.

- Aucune indication sur le pourcentage de code généré par l'IA.

- Incapacité à mettre en œuvre une politique et une gouvernance pour gérer les risques liés aux outils de codage de l'IA.

Notre solution -

Trust Agent : AI

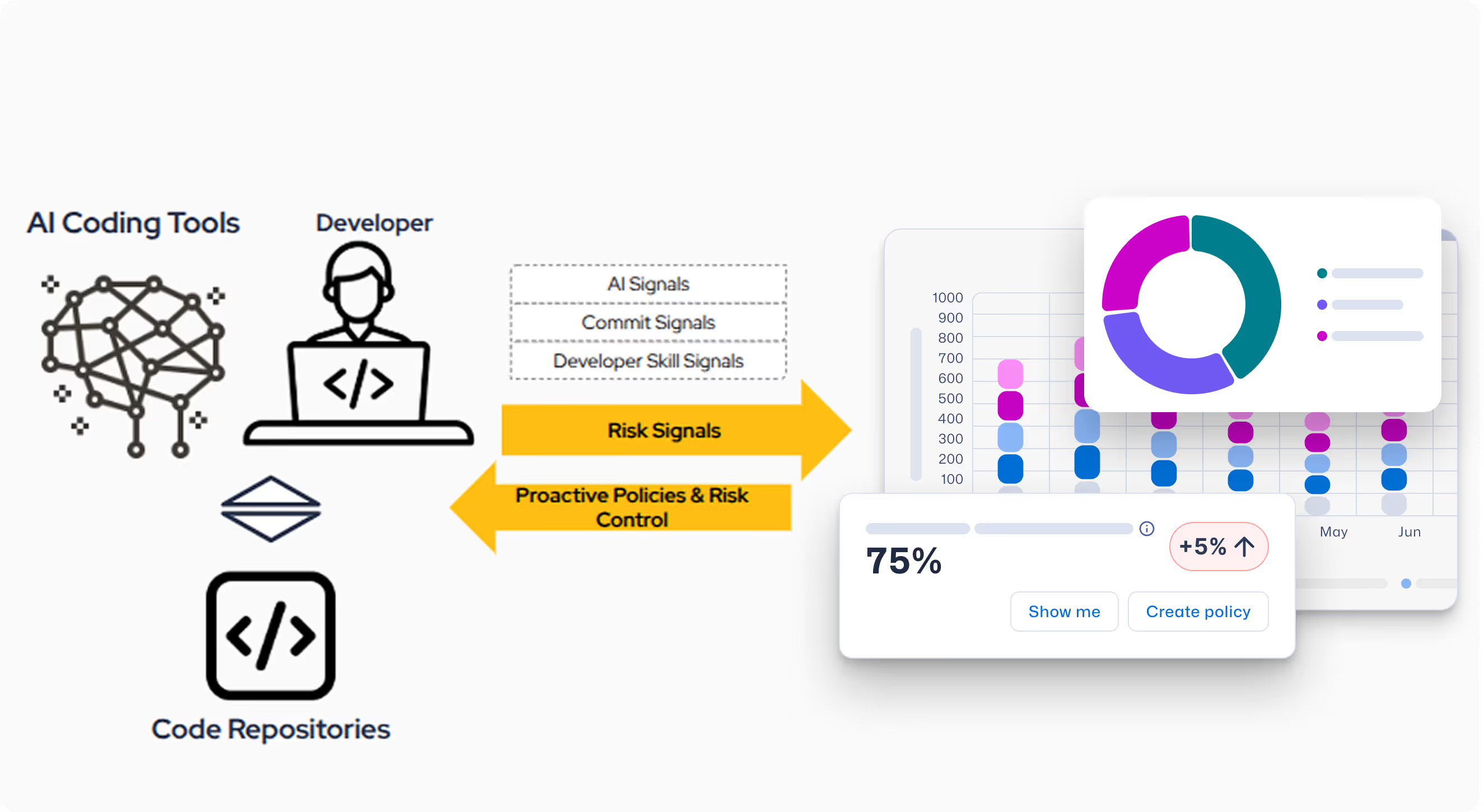

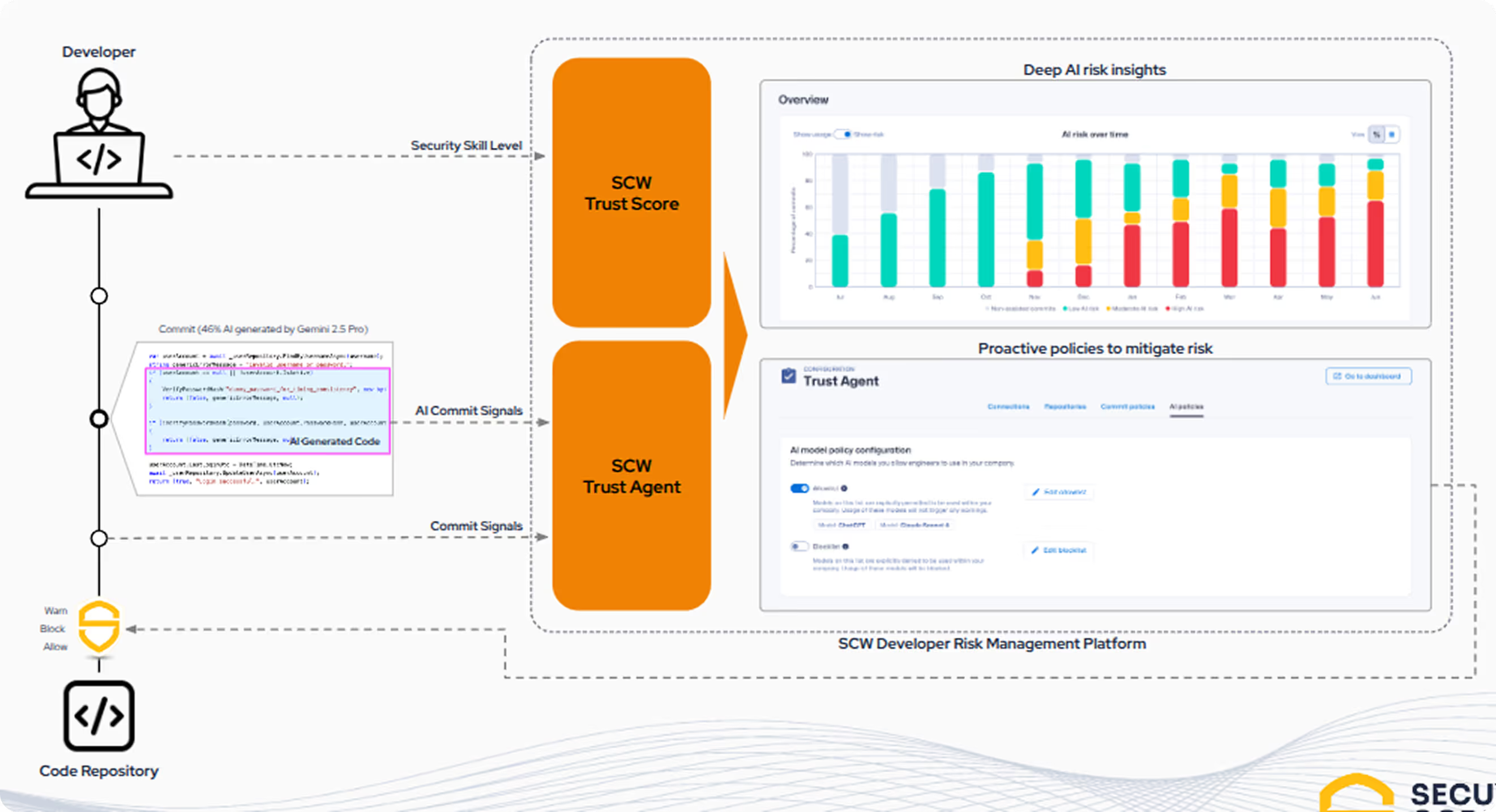

SCW permet aux organisations d'adopter la vitesse du développement basé sur l'IA sans sacrifier la sécurité. Trust Agent : AI est la première solution à offrir une visibilité et une gouvernance en corrélant une combinaison unique de trois signaux clés pour comprendre le risque des développeurs assistés par l'IA au niveau de l'engagement.

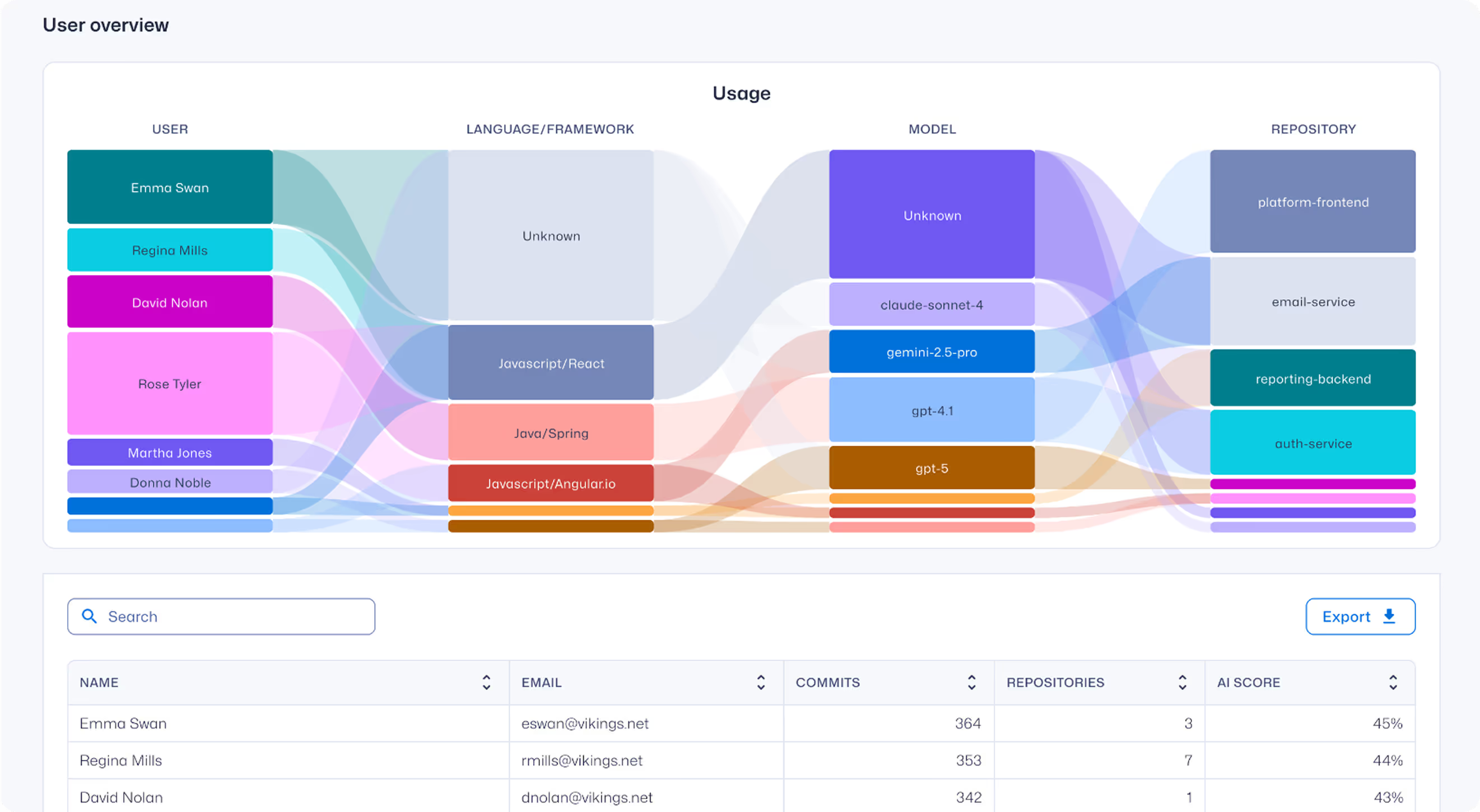

- Utilisation des outils de codage IA : informations sur les utilisateurs des outils de codage IA, des LLM et des MCP, ainsi que sur les référentiels de code concernés.

- Signaux capturés en temps réel : Agent de confiance : L'IA intercepte le code généré par l'IA sur l'ordinateur et l'IDE du développeur.

- Compétences des développeurs en matière de codage sécurisé : Nous fournissons une compréhension claire de la compétence de codage sécurisé d'un développeur, qui est la compétence fondamentale requise pour utiliser l'IA de manière responsable.

Finie l'"IA fantôme"

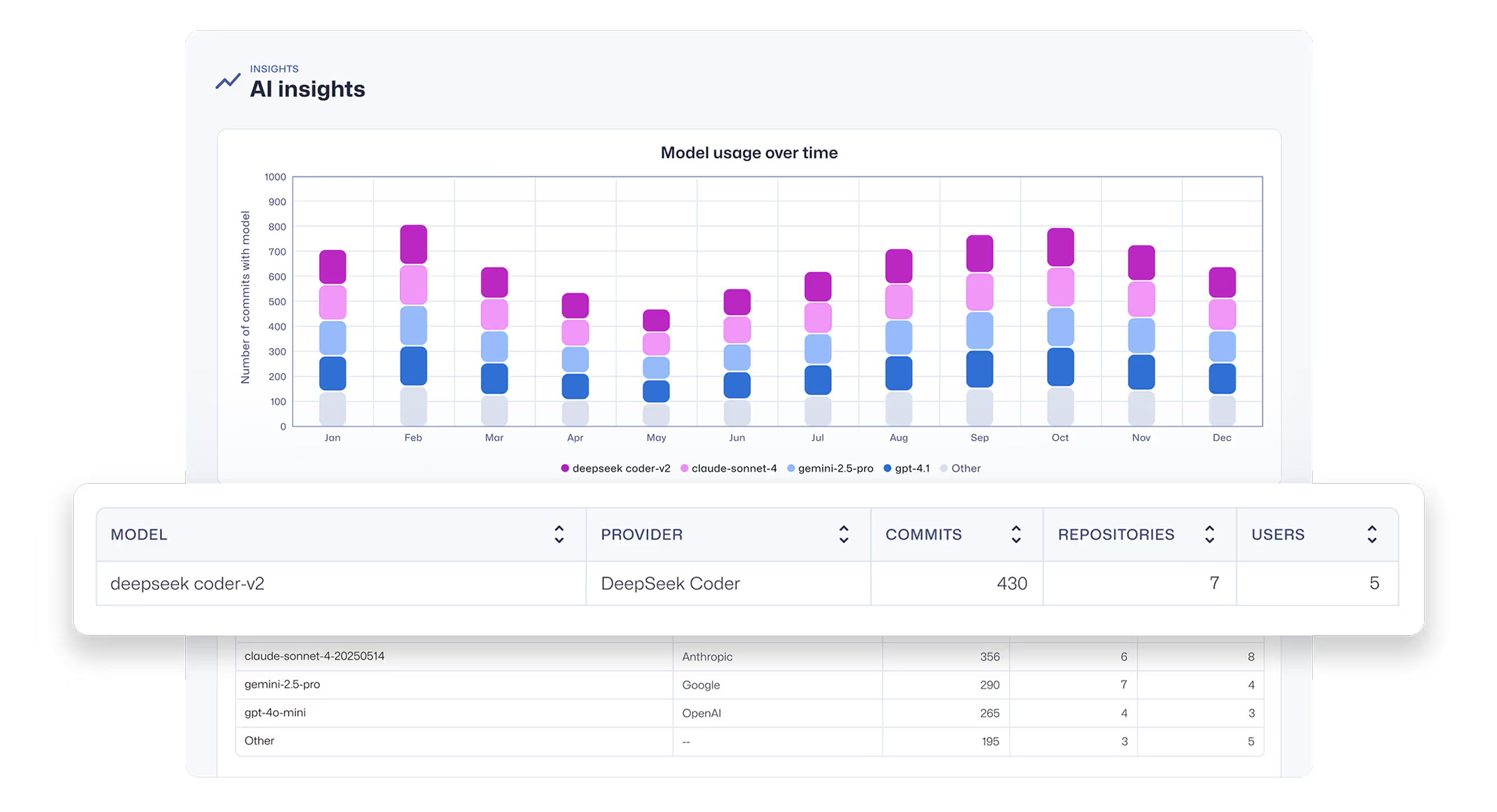

Obtenez une vue d'ensemble des assistants et agents de codage de l'IA, ainsi que des LLM qui les alimentent. Découvrez les outils et les modèles non approuvés.

L'observabilité en profondeur des commits

Bénéficiez d'une visibilité approfondie sur le développement logiciel assisté par l'IA, notamment sur les développeurs qui utilisent quels modèles LLM et MCP, et sur quelles bases de code.

Gouvernance et contrôle intégrés

Connectez le code généré par l'IA aux commits réels pour comprendre le véritable risque de sécurité introduit. Automatisez l'application des politiques pour garantir que les développeurs dotés d'IA respectent les normes de codage sécurisées avant que leurs contributions ne soient acceptées.

Questions sur l'agent fiduciaire : AI Insights

Pourquoi devrais-je me préoccuper des risques liés au code généré par l'IA/LLM dans le cadre de mon cycle de développement durable ?

Alors que les développeurs exploitent de plus en plus les outils de codage de l'IA, une nouvelle couche de risque critique est introduite dans les cycles de développement durable. Des enquêtes montrent que 78 % des développeurs utilisent désormais ces outils, mais des études révèlent que jusqu'à 50 % du code généré par l'IA contient des failles de sécurité.

Ce manque de gouvernance et la déconnexion entre les connaissances des développeurs et la qualité du code peuvent rapidement échapper à tout contrôle, car chaque composant non sécurisé généré par l'IA ajoute à la surface d'attaque de votre organisation, compliquant ainsi les efforts de gestion des risques et de maintien de la conformité.

Pour en savoir plus, consultez ce livre blanc : Les assistants de codage de l'IA : Un guide de navigation sécurisée pour la prochaine génération de développeurs

Quels modèles et outils Trust Agent : AI détecte-t-il ?

Agent de confiance : L'IA collecte des signaux provenant d'assistants d'IA et d'outils de codage agentique tels que GitHub Copilot, Cline, Roo Code, etc. et les LLM qui les alimentent.

Actuellement, nous détectons tous les modèles fournis par OpenAI, Amazon Bedrock, Google Vertex AI et Github Copilot.

Comment Trust Agent : AI ?

Nous vous fournirons un fichier .vsix pour une installation manuelle dans Visual Studio Code, et un déploiement automatisé via des scripts de gestion des appareils mobiles (MDM) pour Intune, Jamf et Kanji sera bientôt disponible.

Comment puis-je m'inscrire à Trust Agent : AI ?

Trust Agent : l'IA est actuellement en version bêta. Si vous êtes intéressé, nous vous invitons à vous inscrire sur notre liste d'attente pour un accès anticipé.

Ressources pour vous aider à démarrer

Codage sécurisé à l'ère de l'IA : essayez nos nouveaux défis interactifs en matière d'IA

Le codage assisté par l'IA est en train de changer le développement. Essayez nos nouveaux défis IA de type Copilot pour réviser, analyser et corriger le code en toute sécurité dans des flux de travail réalistes.

Vibe Coding : Guide pratique pour la mise à jour de votre stratégie AppSec pour l'IA

Regardez à la demande pour apprendre comment permettre aux responsables AppSec de devenir des facilitateurs de l'IA, plutôt que des bloqueurs, grâce à une approche pratique, axée sur la formation. Nous vous montrerons comment tirer parti de Secure Code Warrior (SCW) pour actualiser votre stratégie AppSec à l'ère des assistants de codage IA.

AI Coding Assistants : Un guide de navigation sécurisée pour la prochaine génération de développeurs

Les grands modèles linguistiques offrent des avantages irrésistibles en termes de rapidité et de productivité, mais ils présentent également des risques indéniables pour l'entreprise. Les garde-fous traditionnels ne suffisent pas à contrôler le déluge. Les développeurs ont besoin de compétences précises et vérifiées en matière de sécurité pour identifier et prévenir les failles de sécurité dès le début du cycle de développement du logiciel.

Ressources pour vous aider à démarrer

Cybermon est de retour : Missions IA « Battez le boss » sont Missions disponibles à la demande.

Cybermon 2025 Beat the Boss est désormais disponible toute l'année dans SCW. Déployez des défis de sécurité avancés en matière d'IA/LLM afin de renforcer le développement sécurisé de l'IA à grande échelle.

L'IA peut écrire et réviser du code, mais les humains assument toujours le risque

Le lancement de Claude Code Security par Anthropic marque un point de convergence décisif entre le développement de logiciels assisté par l'IA et l'évolution rapide de notre approche de la cybersécurité moderne.

Explication de la loi sur la cyber-résilience : implications pour le développement de logiciels sécurisés dès la conception

Découvrez les exigences de la loi européenne sur la cyber-résilience (CRA), à qui elle s'applique et comment les équipes d'ingénieurs peuvent s'y préparer grâce à des pratiques de sécurité dès la conception, à la prévention des vulnérabilités et au renforcement des capacités des développeurs.

Facteur 1 : Critères de réussite définis et mesurables

Le catalyseur n° 1 inaugure notre série en 10 parties intitulée « Les catalyseurs de la réussite » en montrant comment relier le codage sécurisé à des résultats commerciaux tels que la réduction des risques et la vitesse pour une maturité à long terme des programmes.

.avif)

.avif)