SCW Trust Agent : AI - Visibilité et gouvernance pour votre SDLC assisté par l'IA

L'adoption généralisée des outils de codage de l'IA transforme le développement de logiciels. Avec 78 % des développeurs1 qui utilisent désormais l'IA pour accroître leur productivité, la vitesse d'innovation n'a jamais été aussi grande. Mais cette accélération rapide s'accompagne d'un risque critique.

Des études révèlent que jusqu'à 50 % des codes générés par l'IA et fonctionnellement corrects ne sont pas sûrs2. Il ne s'agit pas d'un petit bogue, mais d'un problème systémique. Cela signifie que chaque fois qu'un développeur utilise un outil comme GitHub Copilot ou ChatGPT, il peut introduire sans le savoir de nouvelles vulnérabilités dans votre base de code. Il en résulte un dangereux mélange de vitesse et de risques de sécurité que la plupart des organisations ne sont pas équipées pour gérer.

Le défi de l'"IA de l'ombre" (Shadow AI)

Sans moyen de gérer l'utilisation des outils de codage de l'IA, les responsables CISO, AppSec et de l'ingénierie sont exposés à de nouveaux risques qu'ils ne peuvent ni voir ni mesurer. Comment pouvez-vous répondre à des questions cruciales telles que :

- Quel est le pourcentage de notre code généré par l'IA ?

- Quels MCP sont utilisés ?

- Quels modèles non approuvés sont actuellement utilisés ?

- Quelles sont les vulnérabilités générées par les différents modèles ?

Le manque de visibilité et de gouvernance crée une nouvelle couche de risque et d'incertitude. C'est la définition même du "shadow IT", mais pour votre base de code.

Notre solution - Trust Agent : AI

Nous pensons qu'il est possible d'allier vitesse et sécurité. Nous sommes fiers de lancer Trust Agent : AIune nouvelle fonctionnalité puissante de notre produit Trust Agent qui fournit l'observabilité et le contrôle profonds dont vous avez besoin pour adopter en toute confiance l'IA dans le cycle de vie de votre développement logiciel. Grâce à une combinaison unique de signaux, Trust Agent : AI fournit :

- Visibilité : identifiez quels développeurs utilisent quels outils de codage IA, LLM et MCP, et sur quelles bases de code. Finie l'« IA fantôme ».

- Mesure des risques : Reliez le code généré par l'IA au niveau de compétence du développeur et aux vulnérabilités introduites pour comprendre le véritable risque introduit, au niveau de la validation.

- Gouvernance : Automatisez l'application des politiques pour garantir que les développeurs utilisant l'IA respectent les normes de codage sécurisées.

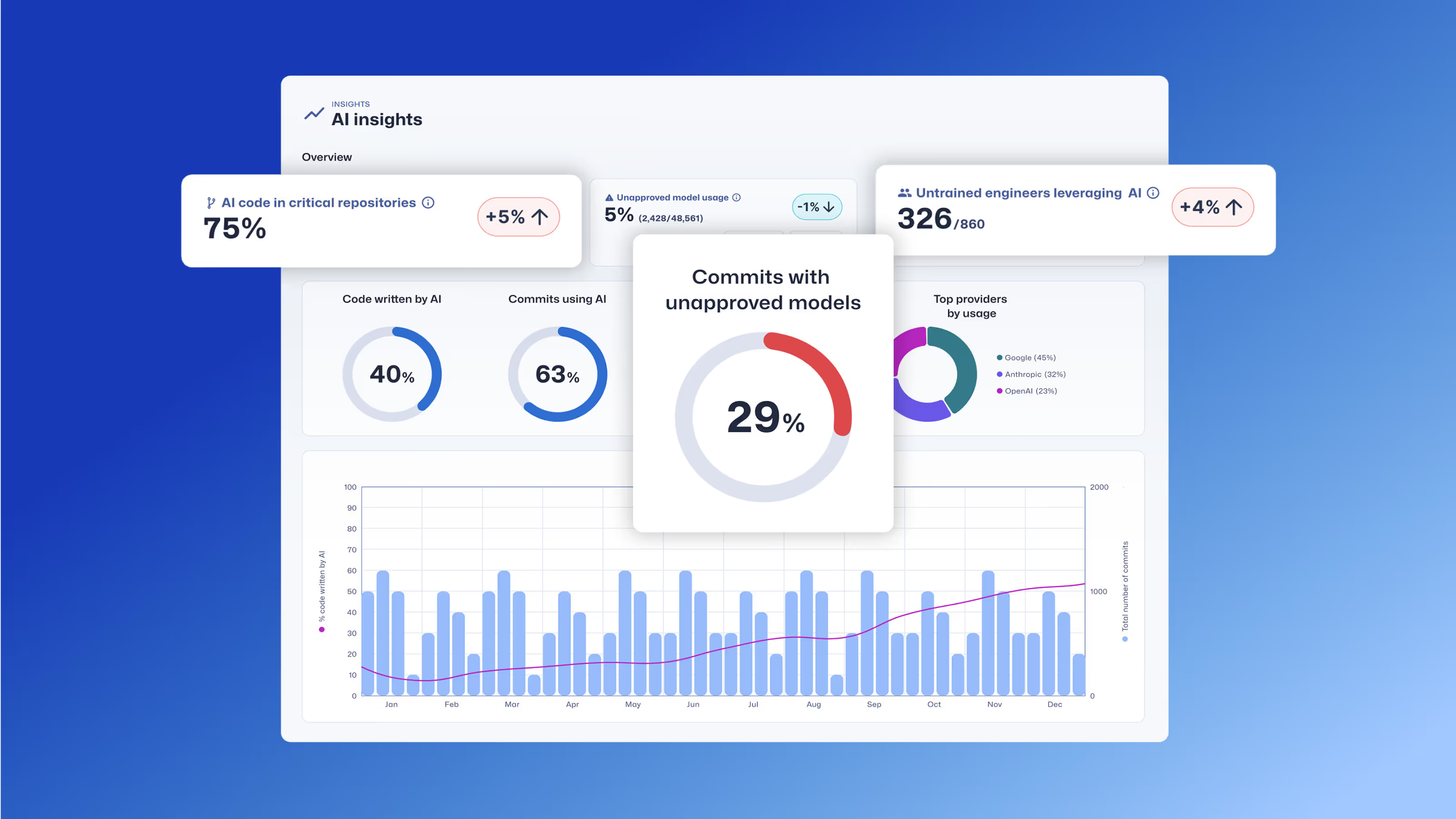

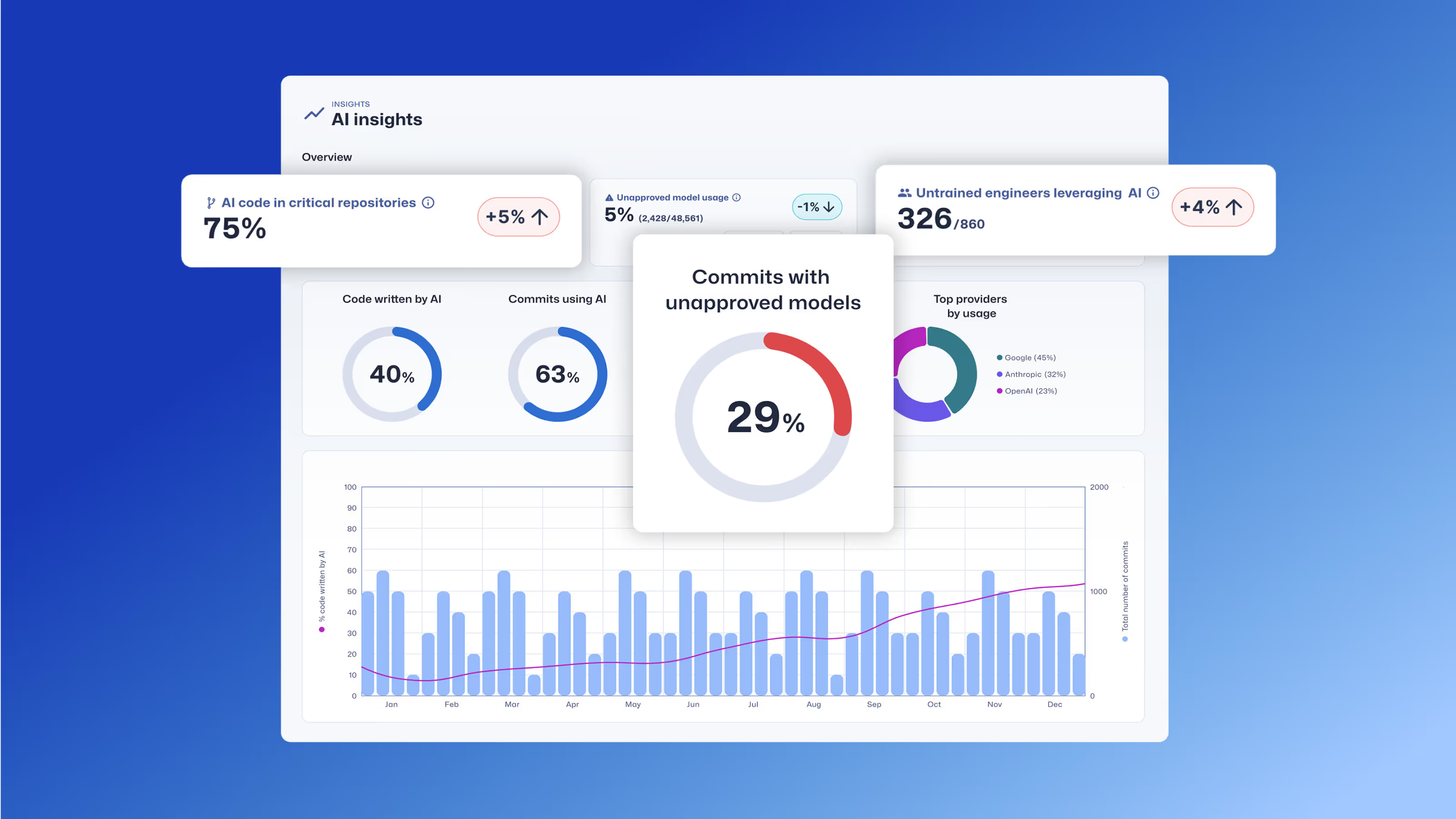

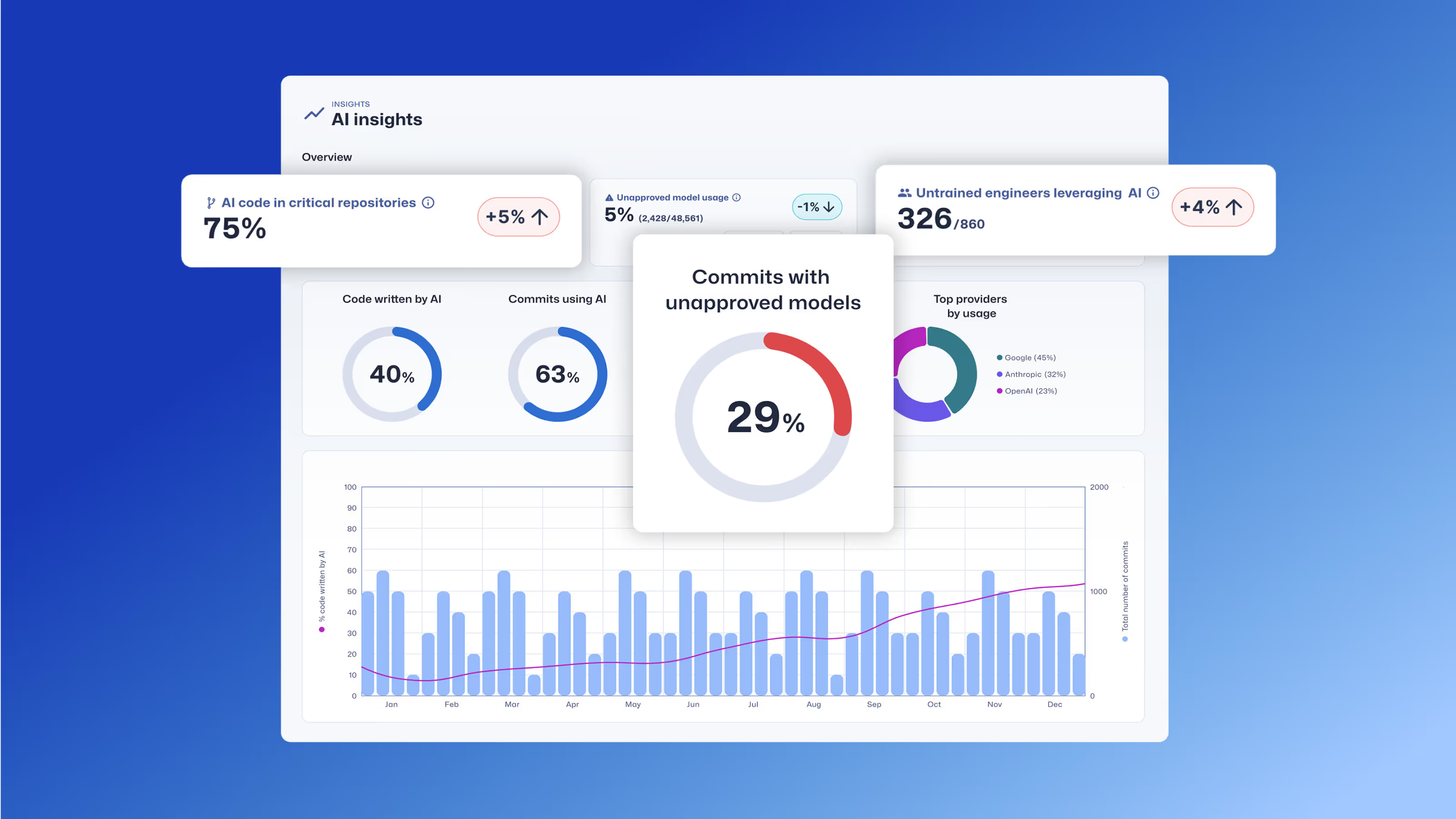

L'agent de confiance : Le tableau de bord de l'IA fournit des informations sur l'utilisation des outils de codage de l'IA, le développeur contributeur, le dépôt de code, et plus encore.

Le rôle du développeur : La dernière ligne de défense

Bien que Trust Agent : AI vous offre une gouvernance sans précédent, nous savons que le développeur reste la dernière ligne de défense, et la plus critique. Le moyen le plus efficace de gérer les risques liés au code généré par l'IA est de s'assurer que vos développeurs possèdent les compétences de sécurité nécessaires pour examiner, valider et sécuriser ce code. C'est là qu'intervient la formation SCW, qui fait partie de notre plateforme complète de gestion des risques pour les développeurs. Avec SCW Learning, nous donnons à vos développeurs les compétences pratiques dont ils ont besoin pour tirer parti de l'IA en toute sécurité pour la productivité. Le produit SCW Learning comprend

- Score de confiance SCW : Une référence inédite qui quantifie les compétences des développeurs en matière de sécurité, vous permettant d'identifier les développeurs les mieux équipés pour gérer le code généré par l'IA.

- Défis IA : Des défis de codage interactifs et réels qui apprennent spécifiquement aux développeurs à trouver et à corriger les vulnérabilités dans le code généré par l'IA.

- Apprentissage ciblé : Des parcours d'apprentissage sélectionnés parmi plus de 200 défis, lignes directrices, parcours, Missions, quêtes et Courses l'IA qui renforcent les principes de codage sécurisé et aident les développeurs à maîtriser les compétences en matière de sécurité nécessaires pour atténuer les risques liés à l'IA.

En combinant la puissante gouvernance de Trust Agent : AI avec le développement des compétences de notre produit d'apprentissage, vous pouvez créer un SDLC véritablement sécurisé. Vous serez en mesure d'identifier les risques, d'appliquer des politiques et de permettre à vos développeurs de créer du code plus rapidement et de manière plus sécurisée que jamais.

Prêt à sécuriser votre parcours en matière d'IA ?

L'ère de l'IA est arrivée, et en tant que chef de produit, mon objectif est de construire des solutions qui ne se contentent pas de résoudre les problèmes d'aujourd'hui, mais qui anticipent ceux de demain. Trust Agent : AI est conçu pour cela, en vous donnant la visibilité et le contrôle nécessaires pour gérer les risques liés à l'IA tout en permettant à vos équipes d'innover. La version bêta d'accès anticipé est maintenant en ligne et nous aimerions que vous en fassiez partie. Il ne s'agit pas seulement d'un nouveau produit ; il s'agit d'être le pionnier d'une nouvelle norme pour le développement de logiciels sécurisés dans un monde où l'IA occupe une place prépondérante.

Rejoignez la liste d'attente de l'accès anticipé dès aujourd'hui !

Découvrez comment Trust Agent : AI offre une visibilité et une gouvernance approfondies sur le code généré par l'IA, ce qui permet aux entreprises d'innover plus rapidement et de manière plus sécurisée.

Secure Code Warrior est là pour vous aider à sécuriser le code tout au long du cycle de vie du développement logiciel et à créer une culture dans laquelle la cybersécurité est une priorité. Que vous soyez responsable AppSec, développeur, CISO ou toute autre personne impliquée dans la sécurité, nous pouvons aider votre organisation à réduire les risques associés à un code non sécurisé.

Réservez une démonstrationTamim Noorzad, directeur de la gestion des produits chez Secure Code Warrior, est un ingénieur devenu gestionnaire de produits avec plus de 17 ans d'expérience, spécialisé dans les produits SaaS 0-to-1.

L'adoption généralisée des outils de codage de l'IA transforme le développement de logiciels. Avec 78 % des développeurs1 qui utilisent désormais l'IA pour accroître leur productivité, la vitesse d'innovation n'a jamais été aussi grande. Mais cette accélération rapide s'accompagne d'un risque critique.

Des études révèlent que jusqu'à 50 % des codes générés par l'IA et fonctionnellement corrects ne sont pas sûrs2. Il ne s'agit pas d'un petit bogue, mais d'un problème systémique. Cela signifie que chaque fois qu'un développeur utilise un outil comme GitHub Copilot ou ChatGPT, il peut introduire sans le savoir de nouvelles vulnérabilités dans votre base de code. Il en résulte un dangereux mélange de vitesse et de risques de sécurité que la plupart des organisations ne sont pas équipées pour gérer.

Le défi de l'"IA de l'ombre" (Shadow AI)

Sans moyen de gérer l'utilisation des outils de codage de l'IA, les responsables CISO, AppSec et de l'ingénierie sont exposés à de nouveaux risques qu'ils ne peuvent ni voir ni mesurer. Comment pouvez-vous répondre à des questions cruciales telles que :

- Quel est le pourcentage de notre code généré par l'IA ?

- Quels MCP sont utilisés ?

- Quels modèles non approuvés sont actuellement utilisés ?

- Quelles sont les vulnérabilités générées par les différents modèles ?

Le manque de visibilité et de gouvernance crée une nouvelle couche de risque et d'incertitude. C'est la définition même du "shadow IT", mais pour votre base de code.

Notre solution - Trust Agent : AI

Nous pensons qu'il est possible d'allier vitesse et sécurité. Nous sommes fiers de lancer Trust Agent : AIune nouvelle fonctionnalité puissante de notre produit Trust Agent qui fournit l'observabilité et le contrôle profonds dont vous avez besoin pour adopter en toute confiance l'IA dans le cycle de vie de votre développement logiciel. Grâce à une combinaison unique de signaux, Trust Agent : AI fournit :

- Visibilité : identifiez quels développeurs utilisent quels outils de codage IA, LLM et MCP, et sur quelles bases de code. Finie l'« IA fantôme ».

- Mesure des risques : Reliez le code généré par l'IA au niveau de compétence du développeur et aux vulnérabilités introduites pour comprendre le véritable risque introduit, au niveau de la validation.

- Gouvernance : Automatisez l'application des politiques pour garantir que les développeurs utilisant l'IA respectent les normes de codage sécurisées.

L'agent de confiance : Le tableau de bord de l'IA fournit des informations sur l'utilisation des outils de codage de l'IA, le développeur contributeur, le dépôt de code, et plus encore.

Le rôle du développeur : La dernière ligne de défense

Bien que Trust Agent : AI vous offre une gouvernance sans précédent, nous savons que le développeur reste la dernière ligne de défense, et la plus critique. Le moyen le plus efficace de gérer les risques liés au code généré par l'IA est de s'assurer que vos développeurs possèdent les compétences de sécurité nécessaires pour examiner, valider et sécuriser ce code. C'est là qu'intervient la formation SCW, qui fait partie de notre plateforme complète de gestion des risques pour les développeurs. Avec SCW Learning, nous donnons à vos développeurs les compétences pratiques dont ils ont besoin pour tirer parti de l'IA en toute sécurité pour la productivité. Le produit SCW Learning comprend

- Score de confiance SCW : Une référence inédite qui quantifie les compétences des développeurs en matière de sécurité, vous permettant d'identifier les développeurs les mieux équipés pour gérer le code généré par l'IA.

- Défis IA : Des défis de codage interactifs et réels qui apprennent spécifiquement aux développeurs à trouver et à corriger les vulnérabilités dans le code généré par l'IA.

- Apprentissage ciblé : Des parcours d'apprentissage sélectionnés parmi plus de 200 défis, lignes directrices, parcours, Missions, quêtes et Courses l'IA qui renforcent les principes de codage sécurisé et aident les développeurs à maîtriser les compétences en matière de sécurité nécessaires pour atténuer les risques liés à l'IA.

En combinant la puissante gouvernance de Trust Agent : AI avec le développement des compétences de notre produit d'apprentissage, vous pouvez créer un SDLC véritablement sécurisé. Vous serez en mesure d'identifier les risques, d'appliquer des politiques et de permettre à vos développeurs de créer du code plus rapidement et de manière plus sécurisée que jamais.

Prêt à sécuriser votre parcours en matière d'IA ?

L'ère de l'IA est arrivée, et en tant que chef de produit, mon objectif est de construire des solutions qui ne se contentent pas de résoudre les problèmes d'aujourd'hui, mais qui anticipent ceux de demain. Trust Agent : AI est conçu pour cela, en vous donnant la visibilité et le contrôle nécessaires pour gérer les risques liés à l'IA tout en permettant à vos équipes d'innover. La version bêta d'accès anticipé est maintenant en ligne et nous aimerions que vous en fassiez partie. Il ne s'agit pas seulement d'un nouveau produit ; il s'agit d'être le pionnier d'une nouvelle norme pour le développement de logiciels sécurisés dans un monde où l'IA occupe une place prépondérante.

Rejoignez la liste d'attente de l'accès anticipé dès aujourd'hui !

L'adoption généralisée des outils de codage de l'IA transforme le développement de logiciels. Avec 78 % des développeurs1 qui utilisent désormais l'IA pour accroître leur productivité, la vitesse d'innovation n'a jamais été aussi grande. Mais cette accélération rapide s'accompagne d'un risque critique.

Des études révèlent que jusqu'à 50 % des codes générés par l'IA et fonctionnellement corrects ne sont pas sûrs2. Il ne s'agit pas d'un petit bogue, mais d'un problème systémique. Cela signifie que chaque fois qu'un développeur utilise un outil comme GitHub Copilot ou ChatGPT, il peut introduire sans le savoir de nouvelles vulnérabilités dans votre base de code. Il en résulte un dangereux mélange de vitesse et de risques de sécurité que la plupart des organisations ne sont pas équipées pour gérer.

Le défi de l'"IA de l'ombre" (Shadow AI)

Sans moyen de gérer l'utilisation des outils de codage de l'IA, les responsables CISO, AppSec et de l'ingénierie sont exposés à de nouveaux risques qu'ils ne peuvent ni voir ni mesurer. Comment pouvez-vous répondre à des questions cruciales telles que :

- Quel est le pourcentage de notre code généré par l'IA ?

- Quels MCP sont utilisés ?

- Quels modèles non approuvés sont actuellement utilisés ?

- Quelles sont les vulnérabilités générées par les différents modèles ?

Le manque de visibilité et de gouvernance crée une nouvelle couche de risque et d'incertitude. C'est la définition même du "shadow IT", mais pour votre base de code.

Notre solution - Trust Agent : AI

Nous pensons qu'il est possible d'allier vitesse et sécurité. Nous sommes fiers de lancer Trust Agent : AIune nouvelle fonctionnalité puissante de notre produit Trust Agent qui fournit l'observabilité et le contrôle profonds dont vous avez besoin pour adopter en toute confiance l'IA dans le cycle de vie de votre développement logiciel. Grâce à une combinaison unique de signaux, Trust Agent : AI fournit :

- Visibilité : identifiez quels développeurs utilisent quels outils de codage IA, LLM et MCP, et sur quelles bases de code. Finie l'« IA fantôme ».

- Mesure des risques : Reliez le code généré par l'IA au niveau de compétence du développeur et aux vulnérabilités introduites pour comprendre le véritable risque introduit, au niveau de la validation.

- Gouvernance : Automatisez l'application des politiques pour garantir que les développeurs utilisant l'IA respectent les normes de codage sécurisées.

L'agent de confiance : Le tableau de bord de l'IA fournit des informations sur l'utilisation des outils de codage de l'IA, le développeur contributeur, le dépôt de code, et plus encore.

Le rôle du développeur : La dernière ligne de défense

Bien que Trust Agent : AI vous offre une gouvernance sans précédent, nous savons que le développeur reste la dernière ligne de défense, et la plus critique. Le moyen le plus efficace de gérer les risques liés au code généré par l'IA est de s'assurer que vos développeurs possèdent les compétences de sécurité nécessaires pour examiner, valider et sécuriser ce code. C'est là qu'intervient la formation SCW, qui fait partie de notre plateforme complète de gestion des risques pour les développeurs. Avec SCW Learning, nous donnons à vos développeurs les compétences pratiques dont ils ont besoin pour tirer parti de l'IA en toute sécurité pour la productivité. Le produit SCW Learning comprend

- Score de confiance SCW : Une référence inédite qui quantifie les compétences des développeurs en matière de sécurité, vous permettant d'identifier les développeurs les mieux équipés pour gérer le code généré par l'IA.

- Défis IA : Des défis de codage interactifs et réels qui apprennent spécifiquement aux développeurs à trouver et à corriger les vulnérabilités dans le code généré par l'IA.

- Apprentissage ciblé : Des parcours d'apprentissage sélectionnés parmi plus de 200 défis, lignes directrices, parcours, Missions, quêtes et Courses l'IA qui renforcent les principes de codage sécurisé et aident les développeurs à maîtriser les compétences en matière de sécurité nécessaires pour atténuer les risques liés à l'IA.

En combinant la puissante gouvernance de Trust Agent : AI avec le développement des compétences de notre produit d'apprentissage, vous pouvez créer un SDLC véritablement sécurisé. Vous serez en mesure d'identifier les risques, d'appliquer des politiques et de permettre à vos développeurs de créer du code plus rapidement et de manière plus sécurisée que jamais.

Prêt à sécuriser votre parcours en matière d'IA ?

L'ère de l'IA est arrivée, et en tant que chef de produit, mon objectif est de construire des solutions qui ne se contentent pas de résoudre les problèmes d'aujourd'hui, mais qui anticipent ceux de demain. Trust Agent : AI est conçu pour cela, en vous donnant la visibilité et le contrôle nécessaires pour gérer les risques liés à l'IA tout en permettant à vos équipes d'innover. La version bêta d'accès anticipé est maintenant en ligne et nous aimerions que vous en fassiez partie. Il ne s'agit pas seulement d'un nouveau produit ; il s'agit d'être le pionnier d'une nouvelle norme pour le développement de logiciels sécurisés dans un monde où l'IA occupe une place prépondérante.

Rejoignez la liste d'attente de l'accès anticipé dès aujourd'hui !

Cliquez sur le lien ci-dessous et téléchargez le PDF de cette ressource.

Secure Code Warrior est là pour vous aider à sécuriser le code tout au long du cycle de vie du développement logiciel et à créer une culture dans laquelle la cybersécurité est une priorité. Que vous soyez responsable AppSec, développeur, CISO ou toute autre personne impliquée dans la sécurité, nous pouvons aider votre organisation à réduire les risques associés à un code non sécurisé.

Voir le rapportRéservez une démonstrationTamim Noorzad, directeur de la gestion des produits chez Secure Code Warrior, est un ingénieur devenu gestionnaire de produits avec plus de 17 ans d'expérience, spécialisé dans les produits SaaS 0-to-1.

L'adoption généralisée des outils de codage de l'IA transforme le développement de logiciels. Avec 78 % des développeurs1 qui utilisent désormais l'IA pour accroître leur productivité, la vitesse d'innovation n'a jamais été aussi grande. Mais cette accélération rapide s'accompagne d'un risque critique.

Des études révèlent que jusqu'à 50 % des codes générés par l'IA et fonctionnellement corrects ne sont pas sûrs2. Il ne s'agit pas d'un petit bogue, mais d'un problème systémique. Cela signifie que chaque fois qu'un développeur utilise un outil comme GitHub Copilot ou ChatGPT, il peut introduire sans le savoir de nouvelles vulnérabilités dans votre base de code. Il en résulte un dangereux mélange de vitesse et de risques de sécurité que la plupart des organisations ne sont pas équipées pour gérer.

Le défi de l'"IA de l'ombre" (Shadow AI)

Sans moyen de gérer l'utilisation des outils de codage de l'IA, les responsables CISO, AppSec et de l'ingénierie sont exposés à de nouveaux risques qu'ils ne peuvent ni voir ni mesurer. Comment pouvez-vous répondre à des questions cruciales telles que :

- Quel est le pourcentage de notre code généré par l'IA ?

- Quels MCP sont utilisés ?

- Quels modèles non approuvés sont actuellement utilisés ?

- Quelles sont les vulnérabilités générées par les différents modèles ?

Le manque de visibilité et de gouvernance crée une nouvelle couche de risque et d'incertitude. C'est la définition même du "shadow IT", mais pour votre base de code.

Notre solution - Trust Agent : AI

Nous pensons qu'il est possible d'allier vitesse et sécurité. Nous sommes fiers de lancer Trust Agent : AIune nouvelle fonctionnalité puissante de notre produit Trust Agent qui fournit l'observabilité et le contrôle profonds dont vous avez besoin pour adopter en toute confiance l'IA dans le cycle de vie de votre développement logiciel. Grâce à une combinaison unique de signaux, Trust Agent : AI fournit :

- Visibilité : identifiez quels développeurs utilisent quels outils de codage IA, LLM et MCP, et sur quelles bases de code. Finie l'« IA fantôme ».

- Mesure des risques : Reliez le code généré par l'IA au niveau de compétence du développeur et aux vulnérabilités introduites pour comprendre le véritable risque introduit, au niveau de la validation.

- Gouvernance : Automatisez l'application des politiques pour garantir que les développeurs utilisant l'IA respectent les normes de codage sécurisées.

L'agent de confiance : Le tableau de bord de l'IA fournit des informations sur l'utilisation des outils de codage de l'IA, le développeur contributeur, le dépôt de code, et plus encore.

Le rôle du développeur : La dernière ligne de défense

Bien que Trust Agent : AI vous offre une gouvernance sans précédent, nous savons que le développeur reste la dernière ligne de défense, et la plus critique. Le moyen le plus efficace de gérer les risques liés au code généré par l'IA est de s'assurer que vos développeurs possèdent les compétences de sécurité nécessaires pour examiner, valider et sécuriser ce code. C'est là qu'intervient la formation SCW, qui fait partie de notre plateforme complète de gestion des risques pour les développeurs. Avec SCW Learning, nous donnons à vos développeurs les compétences pratiques dont ils ont besoin pour tirer parti de l'IA en toute sécurité pour la productivité. Le produit SCW Learning comprend

- Score de confiance SCW : Une référence inédite qui quantifie les compétences des développeurs en matière de sécurité, vous permettant d'identifier les développeurs les mieux équipés pour gérer le code généré par l'IA.

- Défis IA : Des défis de codage interactifs et réels qui apprennent spécifiquement aux développeurs à trouver et à corriger les vulnérabilités dans le code généré par l'IA.

- Apprentissage ciblé : Des parcours d'apprentissage sélectionnés parmi plus de 200 défis, lignes directrices, parcours, Missions, quêtes et Courses l'IA qui renforcent les principes de codage sécurisé et aident les développeurs à maîtriser les compétences en matière de sécurité nécessaires pour atténuer les risques liés à l'IA.

En combinant la puissante gouvernance de Trust Agent : AI avec le développement des compétences de notre produit d'apprentissage, vous pouvez créer un SDLC véritablement sécurisé. Vous serez en mesure d'identifier les risques, d'appliquer des politiques et de permettre à vos développeurs de créer du code plus rapidement et de manière plus sécurisée que jamais.

Prêt à sécuriser votre parcours en matière d'IA ?

L'ère de l'IA est arrivée, et en tant que chef de produit, mon objectif est de construire des solutions qui ne se contentent pas de résoudre les problèmes d'aujourd'hui, mais qui anticipent ceux de demain. Trust Agent : AI est conçu pour cela, en vous donnant la visibilité et le contrôle nécessaires pour gérer les risques liés à l'IA tout en permettant à vos équipes d'innover. La version bêta d'accès anticipé est maintenant en ligne et nous aimerions que vous en fassiez partie. Il ne s'agit pas seulement d'un nouveau produit ; il s'agit d'être le pionnier d'une nouvelle norme pour le développement de logiciels sécurisés dans un monde où l'IA occupe une place prépondérante.

Rejoignez la liste d'attente de l'accès anticipé dès aujourd'hui !

Table des matières

Secure Code Warrior est là pour vous aider à sécuriser le code tout au long du cycle de vie du développement logiciel et à créer une culture dans laquelle la cybersécurité est une priorité. Que vous soyez responsable AppSec, développeur, CISO ou toute autre personne impliquée dans la sécurité, nous pouvons aider votre organisation à réduire les risques associés à un code non sécurisé.

Réservez une démonstrationTéléchargerRessources pour vous aider à démarrer

Loi sur la cyber-résilience (CRA) Parcours d'apprentissage alignés

SCW soutient la préparation à la loi sur la cyber-résilience (CRA) grâce à des quêtes alignées sur la CRA et des collections d'apprentissage conceptuel qui aident les équipes de développement à acquérir les compétences nécessaires en matière de conception sécurisée, de SDLC et de codage sécurisé, conformément aux principes de développement sécurisé de la CRA.

La Chambre de commerce établit la norme en matière de sécurité à grande échelle axée sur les développeurs

La Chambre de commerce néerlandaise explique comment elle a intégré le codage sécurisé dans le développement quotidien grâce à des certifications basées sur les rôles, à l'évaluation comparative du Trust Score et à une culture de responsabilité partagée en matière de sécurité.

Modélisation des menaces avec l'IA : transformer chaque développeur en modélisateur de menaces

Vous repartirez mieux équipé pour aider les développeurs à combiner les idées et les techniques de modélisation des menaces avec les outils d'IA qu'ils utilisent déjà pour renforcer la sécurité, améliorer la collaboration et créer des logiciels plus résilients dès le départ.

Ressources pour vous aider à démarrer

Explication de la loi sur la cyber-résilience : implications pour le développement de logiciels sécurisés dès la conception

Découvrez les exigences de la loi européenne sur la cyber-résilience (CRA), à qui elle s'applique et comment les équipes d'ingénieurs peuvent s'y préparer grâce à des pratiques de sécurité dès la conception, à la prévention des vulnérabilités et au renforcement des capacités des développeurs.

Facteur 1 : Critères de réussite définis et mesurables

Le catalyseur n° 1 inaugure notre série en 10 parties intitulée « Les catalyseurs de la réussite » en montrant comment relier le codage sécurisé à des résultats commerciaux tels que la réduction des risques et la vitesse pour une maturité à long terme des programmes.

.avif)

%20(1).avif)

.avif)